딥시크(Deepseek) 로컬 사용법(올라마 + Open WebUI, LMstudio) - 딥시크 모델 다운로드

로컬에서 딥시크(DeepSeek) 모델 쉽게 사용하기

딥시크(DeepSeek) 모델을 로컬 pc에서 간편하게 사용하려면 두 가지 방법이 있습니다.

1. Ollama(올라마) + Open WebUI

2. LM Studio

맥, 리눅스 터미널, 윈도우 파워쉘 사용이 익숙하지 않다면 LM Studio를 이용하는 것이 가장 쉽습니다.

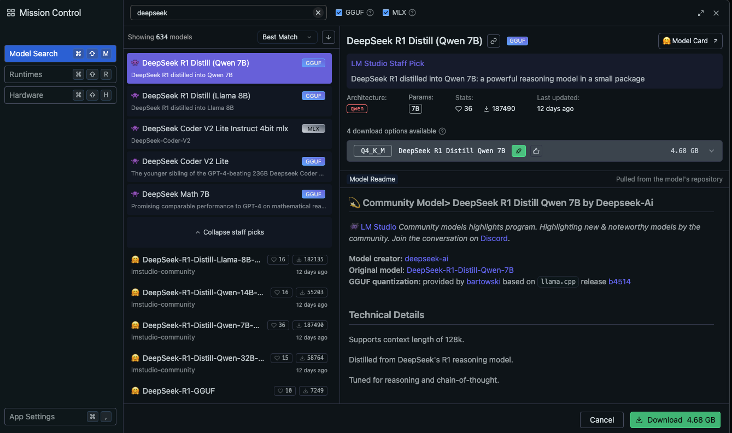

LM Studio에서 딥시크(DeepSeek) 모델 다운로드 및 사용법

LM Studio 설치 및 다운로드 방법에 대해 모르시는 분은 아래글을 참고하시면 됩니다.

LM Studio 기능 및 사용법 - Llama 3.1-7B 로컬 챗봇 만들기(파이썬)

LM Studio 다운로드먼저 LM Studio를 사용하기 위해서는 다운로드하셔야 합니다. 링크를 들어가시면 다운로드 받으실 수 있습니다. 다운로드 링크 : LM Stuido 다운로드링크를 통해 들어가시면 다음과

hyunicecream.tistory.com

LM Studio를 실행한 후 4번째 탭에 있는 Discover를 선택하신 후 "deepseek"를 검색하시면 됩니다.

- DeepSeek R1 → ChatGPT o1과 같은 추론 모델을 사용하고 싶다면 선택

- DeepSeek V3 → ChatGPT 4o, Claude 3.5 Sonnet처럼 텍스트 모델을 원한다면 선택

DeepSeek 모델의 아키텍쳐를 보시면 Qwen 기반과 Llama 기반의 모델이 있는데, 간단히 정리하면 다음과 같습니다.

- Qwen: 중국 알리바바에서 개발한 언어 모델

- Llama: Meta에서 개발한 언어 모델

개인 컴퓨터에서 실행할 경우, 8B 이상의 모델을 사용하면 성능 부담이 커질 수 있습니다.

실행 직후 시스템이 멈출 수도 있으니, 일반적인 PC 사용자는 8B 이하 모델을 선택하는 것이 좋습니다.

모델 선택 가이드

| 하드웨어 성능 | 추천 모델 | 활용 예시 |

| 일반 노트북/데스크탑 (16GB RAM, 6GB VRAM 이상) | 7B ~ 8B 모델 | AI 챗봇, 코드 도우미, 문서 요약 |

| 고성능 데스크탑 (32GB RAM, 12GB VRAM 이상) | 13B ~ 14B 모델 | 코드 생성, 글쓰기, 데이터 분석 |

| 워크스테이션/서버급 장비 (64GB RAM, 24GB VRAM 이상) | 30B 이상 | 파인튜닝, 연구 목적, 대규모 분석 |

| 사용 목적 | 추천 모델 |

| 가벼운 일상용 챗봇 & 생산성 도구 (글 작성, 이메일 초안, 문서 요약 등) | 7B ~ 8B 모델 |

| 코딩 도우미 & 기술 문서 요약 (코드 생성, 디버깅, 프로그래밍 지원) | 14B 이상 모델 |

| 고급 분석 & AI 연구 (대규모 데이터 처리, LLM 튜닝, 연구 목적) | 30B 이상 모델 |

모델 다운로드 후 실행하기

원하는 모델을 다운로드한 후, LM Studio의 첫 번째 탭인 Chat에서 "Select a model to load"를 클릭하여 다운로드한 모델을 선택하면 바로 사용할 수 있습니다.

여기서 다운 받으신 딥시크 모델을 선택하시고 채팅하시면 됩니다.

저는 올라마로 사용하기 때문에 다운로드하지 않았습니다.

Ollama + OpenWeb UI로 딥시크(DeepSeek) 모델 다운로드 및 사용법

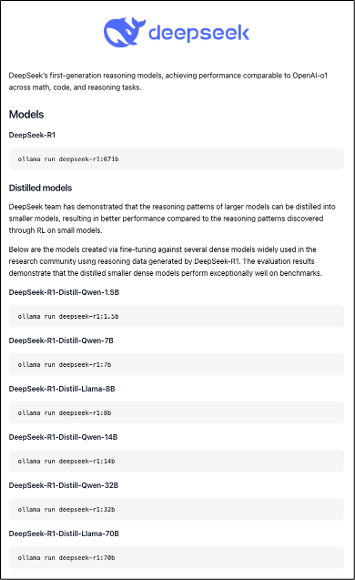

Ollama 홈페이지에서 "DeepSeek"을 검색하면 관련 모델을 찾을 수 있습니다.

여기서도 Qwen 기반 모델과 Llama 기반 모델을 선택할 수 있습니다.

다운 받을 수 있는 목록리스트입니다. 원하시는 모델을 다운 받으시면 됩니다.

저는 DeepSeek-R1-Distill-Qwen-7B로 다운 받았습니다.

딥시크 모델 설치하기(터미널)

1. Ollama 홈페이지에서 원하는 모델을 선택합니다.

2. 터미널에 제공된 명령어를 입력하여 설치합니다. 설치하는데 시간이 오래 걸리지 않고, 금방 설치가 됩니다.

ollama run deepseek-r1:7b3. 다운로드가 완료되면 "send a message" 메시지가 표시됩니다.

터미널 내에서 사용하실 수 있는데, 추천하지는 않습니다.

4. 종료하려면 "/bye"를 입력하면 됩니다.

5. 종료하고, Docker(도커)로 이동하여 Open WebUI로 실행하면 끝 입니다.

Open-WebUI에서 딥시크 모델 실행하기

설치방법에 대해 잘 모르시는 분은 해당 글을 보고 Open-WebUI를 설치하시면 됩니다.

Open-WebUI 설치 및 사용법 - Ollama(올라마) with Docker

시작하기 앞서...Docker를 사용해서, 인터넷 없이도 1인 또는 그룹에서 사용할 수 있는 챗봇을 만들어보려고 합니다.챗봇 툴: 오픈 소스인 Open-WebUI모델 관리 및 실행 플랫폼 : Ollama(올라마)사용 모

hyunicecream.tistory.com

Docker에서 Open-WebUI를 실행합니다.

Open-WebUI를 실행하면 설치된 딥시크 모델이 자동으로 감지됩니다.

아래 캡쳐된 이미지와 같이 모델 목록에서 원하는 모델을 클릭하면 바로 사용할 수 있습니다.

딥시크 R1 추론 모델 사용화면

여기서 보시면

<think>

</think>

범주안에 있는 텍스트는 딥시크가 질문에 대해 추론하는 과정을 보여줍니다. 그리고 아래 추론에 따른 답변을 하시는 걸 볼 수 있습니다.

개인이 추론모델을 공짜로 사용할 수 있다는 거에 대해 엄청난 메리트가 있습니다.

단점 : 영어, 중국어 외에 언어 성능이 별로이기 때문에 제한적이다.

딥시크(Deepseek) 홈페이지에서 사용할 수 있는 모델은 엄청 큰 모델이기 때문에 영어, 중국어를 제외한 다른 언어도(한국어) 잘하지만, 개인이 사용하기에 모델 크기에 제한이 있다 보니, 아무래도 중국어, 영어 외에는 좀 제한적입니다.

딥시크 R1 추론 모델 사용

레시피 질문

김치를 집에서 만드는 방법에 대해 질문했더니, 다음과 같이 추론하는 과정을 볼 수 있습니다.

추론 모델 답게 확실히 생각하는 과정이 길다는 것을 눈으로 확인하실 수 있습니다.

저희가 알고 있는 김치가 아닌 중국 절임 배추에 대해 설명하고 있습니다.

답변의 구조는 잘 만들어 주는 것을 확인할 수 있습니다.

저희가 알고 있는 김치가 아닌 중국의 절임 배추에 대해 설명해주었기 때문에, 후속 질문으로 어느나라의 전통음식이냐고 물어보았습니다.

후속질문에 대한 답변으로는 김치는 한국의 전통 음식이라고 하는 답변을 볼 수 있었습니다.

코드 생성 질문

타이타닉 데이터에 대해 연습을 할 수 있도록 샘플 코드를 만들어 달라고 질문 하였습니다.

아까와 마찬가지로 긴 추론 단계를 거치고 만들어 주었습니다.

코드도 단계별로 잘 정리해서 설명해주고, 전체적인 코드까지 전달해주는 것을 확인할 수 있습니다.

사용 후기 - 결론

전에는 개인이 사용하기에 ChatGPT o1 API를 사용하기에 부담이었지만 추론 모델을 로컬에서 이 정도 사용할 수 있으면 엄청난 메리트인것 같습니다.(언어가 제한적이지만...)

개인만의 로컬 GPT를 만들고 싶고, 사용하고 싶으신분들은 보다 프롬프트나 모델 설정을 통해 고도화 시킬 수 있으니 사용해보시는 걸 추천드립니다.

번외

딥시크(DeepSeek) 홈페이지에 있는 모델을 사용할 때

스스로 생각하면서 놓친게 있는지 그리고 교차 검증을 하는 것이 많이 놀라웠습니다.

이러한 모델을 비용없이 공짜로 그리고 오픈소스로 풀었다는게 참 대단한 것 같습니다...

홈페이지에서 사용해보시고 싶으신 분들은 아래 링크를 통해 한 번 사용해보세요.

딥시크 사용하러 가기 : https://chat.deepseek.com/

댓글